Daniel Kanheman s’est éteint le 27 mars dernier à l’âge de 90 ans. Ce psychologue et économiste américano-israélien est largement reconnu pour son travail en psychologie cognitive et en économie comportementale. Aux côtés d’Amos Tversky, D. Kahneman a développé la théorie des perspectives. Celle-ci décrit la manière dont les individus évaluent de façon asymétrique leurs perspectives de perte et de gain. Les deux chercheurs ont également identifié plusieurs heuristiques et biais cognitifs qui affectent le comportement humain. Ces recherches ont valu à D. Kahneman le prix Nobel d’économie en 2002.

Nous nous sommes déjà penchés il y a plus de 10 ans sur les recherches de D. Kahneman dans une série de 11 articles sur la finance comportementale. Nous souhaitons aujourd’hui lui rendre hommage dans un édito consacré à ses travaux, aux principaux biais cognitifs auxquels sont confrontés les investisseurs, ainsi qu’aux moyens permettant de les atténuer.

Les 2 modes de pensées

Kahneman utilise une distinction déjà présente en psychologie, la distinction entre 2 modes de raisonnement :

– le système 1. Il s’agit du système cognitif qui fonctionne de manière automatique, intuitive, associative et rapide. Il est peu couteux en énergie et ce système de raisonnement est donc souvent utilisé par défaut. Il est difficile à contrôler et à modifier.

– le système 2. Il intervient dans la résolution de problèmes complexes. Il est plus lent, plus délibératif et plus logique que le système 1.

L’accessibilité des pensées

Une autre idée centrale des travaux de D. Kahneman est l’accessibilité des pensées, c’est-à-dire la facilité avec laquelle des contenus mentaux particuliers nous viennent à l’esprit.

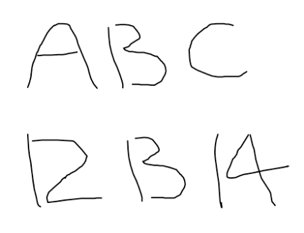

L’image ci-dessous illustre l’effet du contexte sur l’accessibilité. Un stimulus ambigu qui est perçu comme une lettre (B) dans un contexte de lettres est perçu comme un chiffre (13) dans un contexte de chiffres.

L’image illustre également un autre point : l’ambiguïté est supprimée dans la perception. Cet aspect de la démonstration est gâché pour le lecteur qui voit les deux versions à proximité l’une de l’autre, mais lorsque les deux lignes sont montrées séparément, les observateurs ne prennent pas spontanément conscience de l’interprétation alternative. Ils « voient » l’interprétation la plus probable dans son contexte, mais n’ont aucune indication subjective qu’elle pourrait être perçue différemment.

Maps of bounded rationality: a perspective on intuitive judgment and choice (Daniel Kahneman)

Les effets de cadrage

Les effets de cadrage montrent comment la présentation ou le contexte d’un problème influence les décisions. Par exemple, les mêmes options peuvent être perçues différemment si elles sont présentées en termes de gains potentiels plutôt qu’en termes de pertes potentielles.

Dans une démonstration célèbre d’un effet de cadrage, McNeill, Pauker, Sox et Tversky (1982) ont induit des choix différents entre la chirurgie et la radiothérapie en décrivant les statistiques de résultats en termes de taux de survie ou de taux de mortalité. Comme une survie à court terme de 90% est moins menaçante qu’une mortalité immédiate de 10%, le cadre de la survie a donné lieu à une préférence nettement plus marquée pour la chirurgie.

La théorie des perspectives

L’idée centrale de la théorie des perspectives est que les changements et les différences sont beaucoup plus accessibles pour notre cerveau qu’un niveau absolu de stimulation (Palmer, 1999).

La perception est dépendante de la référence. Les attributs perçus d’un stimulus focal reflètent le contraste entre ce stimulus et un contexte de stimuli antérieurs et concomitants.

L’image ci-dessous illustre la dépendance de la référence dans la vision. Les deux carrés au centre ont la même luminance (énergie lumineuse qui atteint l’œil) mais ils n’ont pas la même luminosité. L’intérêt de cette démonstration est que la luminosité d’une zone n’est pas une fonction à paramètre unique de l’énergie lumineuse qui atteint l’œil à partir de cette zone. La luminosité perçue dépend également de la luminance des zones voisines.

Maps of bounded rationality: a perspective on intuitive judgment and choice (Daniel Kahneman)

La valeur de référence à laquelle la stimulation est comparée reflète également l’historique de l’adaptation à la stimulation antérieure. Une démonstration courante de cette théorie repose sur l’expérience suivante. Trois seaux d’eau de températures différentes sont disposés du froid à gauche au chaud à droite, en passant par le tiède au milieu. Dans la phase d’adaptation, la main gauche et la main droite sont immergées respectivement dans l’eau froide et dans l’eau chaude. Les sensations de froid et de chaleur, initialement intenses, s’atténuent progressivement. Lorsque les deux mains sont ensuite immergées dans le seau du milieu, l’expérience est celle de la chaleur dans la main gauche et du froid dans la main droite.

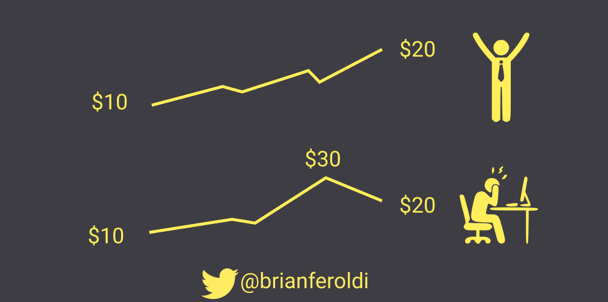

Dans le domaine de l’investissement, la théorie des perspectives suggère que les changements de richesse importent davantage que l’état final. L’image ci-dessous (merci AntonyP) illustre parfaitement cette idée.

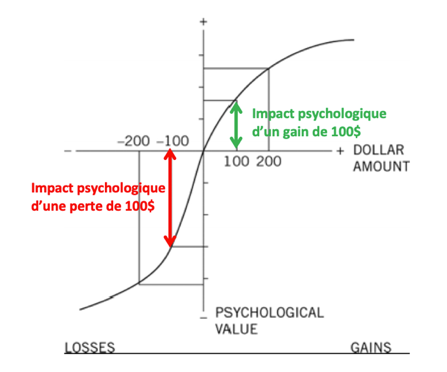

Une autre caractéristique de la théorie des perspectives est l’aversion à la perte. Lorsqu’elles sont directement comparées ou pondérées les unes par rapport aux autres, les pertes pèsent davantage que les gains. Ce principe est illustré dans le graphique ci-dessous.

source : Thinking, Fast and Slow (Daniel Kahneman)

La courbe a deux parties distinctes, à gauche et à droite du point 0, avec une forme de S, ce qui signifie que la réponse psychologique diminue à mesure que les gains et les pertes augmentent. En revanche, la courbe n’est pas symétrique. La pente de la courbe change brutalement à partir du point 0. La réponse psychologique à la perte est plus forte que la réponse au gain. C’est l’aversion à la perte.

Se focaliser exclusivement sur l’état final, et donc faire abstraction des gains et des pertes à court terme, est peu réaliste en pratique car la vie est vécue dans le présent. L’utilité espérée (valeur psychologique que chaque individu accorde à un bien) ne peut être dissociée de l’émotion et l’émotion est déclenchée par les changements.

Ainsi, d’après D. Kahneman, une théorie du choix qui ignorent complètement les émotions, telles que la douleur des pertes et le regret des erreurs n’est pas pertinente.

Substitution d’attributs

Une autre heuristique clé est la substitution d’attributs, c’est-à-dire répondre à une question difficile en la remplaçant par une question plus simple et plus accessible. Cela peut conduire à des erreurs systématiques dans le jugement et la prise de décision.

Trois heuristiques de jugement, appelées représentativité, disponibilité et ancrage, ont été décrites dans une étude de Tversky et Kahneman, ainsi qu’une douzaine de biais systématiques, dont la négligence des informations de base, l’excès de confiance et la surestimation de la fréquence d’événements faciles à se rappeler.

Pour un exemple perceptif de substitution d’attributs, considérons la question suivante :

« Quelle est la taille des deux chevaux dans l’image ci-dessous, tels qu’ils sont représentés sur la page ? »

Maps of bounded rationality: a perspective on intuitive judgment and choice (Daniel Kahneman)

Les chevaux sont en fait de taille identique, mais la photo produit une illusion convaincante.

La caractéristique cible que l’observateur doit rapporter est la taille bidimensionnelle, mais les réponses apportées suggèrent une perception tridimensionnelle. Dans les termes du modèle, la taille tridimensionnelle est l’attribut heuristique.

Comme dans d’autres cas de substitution d’attributs, l’illusion est causée par une différence d’accessibilité. L’impression de taille tridimensionnelle est la seule qui vienne à l’esprit des observateurs naïfs – les peintres et les photographes expérimentés peuvent faire mieux – et elle produit une illusion perceptive dans le jugement de la taille de l’image.

Les illusions cognitives produites par la substitution d’attributs ont le même caractère : l’impression d’un attribut est mise en correspondance avec l’échelle d’un autre attribut, et le juge n’est normalement pas conscient de la substitution.

Principaux biais cognitifs dans le domaine de l’investissement

Voici une liste des principaux biais cognitifs auxquels sont confrontés les investisseurs.

Biais de confirmation / « storytelling ». Tendance à rechercher, interpréter et se souvenir des informations d’une manière qui confirme ses opinions.

exemple : un investisseur qui croit fermement en une entreprise cherchera des informations qui soutiennent sa croyance et ignorera les nouvelles négatives.

Biais de disponibilité. Juger la fréquence ou la probabilité d’un événement en fonction de la facilité avec laquelle des exemples viennent à l’esprit.

exemple : après une crise financière, les investisseurs peuvent exagérer la probabilité d’une autre crise similaire dans un avenir proche.

Biais de représentativité. Juger la probabilité d’un événement en fonction de sa similarité avec une classe d’événements existants.

exemple : un investisseur pourrait supposer qu’une entreprise en croissance rapide est une bonne opportunité d’investissement simplement parce qu’elle ressemble à des entreprises prospères du passé, sans considérer les fondamentaux actuels.

Effet de halo. La perception d’une personne ou d’une entreprise est influencée par une impression générale, positive ou négative.

exemple : si une entreprise est reconnue pour son innovation, les investisseurs pourraient surestimer ses autres qualités.

Biais rétrospectif. Tendance à juger une situation passée avec des données disponibles après les faits. Une fois un événement advenu, nous oublions à quel point il était imprévisible.

exemple : j’étais sûr que l’entreprise X allait publier d’excellents résultats. J’aurais dû renforcer ma ligne avant la publication.

Biais du survivant. Tendance à tirer des conclusions à partir d’un échantillon excluant les échecs.

exemple : le biais du survivant survient lors de l’exclusion des études de performance d’entreprises ayant fait faillite.

Excès de confiance. Propension à surestimer nos aptitudes à réaliser une tâche, dans l’absolu et relativement aux autres.

Biais d’ancrage. Tendance à se fier trop fortement à la première information (l’ancre).

exemple : j’achète une action avec un prix de revient de 10 EUR. Le cours de l’action a beaucoup baissé, mais je n’envisage pas de vendre mes titres avant que le cours de l’action ne remonte à 10 EUR. Le prix de revient n’a pourtant aucun rapport avec la valeur intrinsèque de l’action.

Biais de statu quo. Préférence pour maintenir les choses en l’état plutôt que de changer.

exemple : les investisseurs pourraient éviter de se séparer d’une position même si la thèse d’achat initial n’est plus d’actualité.

Biais d’aversion à la perte. La douleur de perdre est psychologiquement deux fois plus puissante que le plaisir de gagner.

exemple : Les investisseurs sont souvent réticents à vendre des actions en perte, espérant qu’elles remonteront, même lorsque les perspectives sont négatives. Acter une perte c’est aussi reconnaître un échec et l’acter définitivement.

Effet de dotation. Tendance à attribuer plus de valeur aux choses simplement parce qu’on les possède.

exemple : les investisseurs peuvent évaluer les actions qu’ils détiennent plus favorablement que des actions similaires qu’ils ne possèdent pas.

Comment atténuer nos biais ?

Le système 1 n’envoie pas de signal d’alerte lorsqu’il devient peu fiable. Les réponses intuitives arrivent à l’esprit rapidement et avec certitude, que la réponse émane d’une compétence avérée ou d’une heuristique, c’est-à-dire d’un raccourci visant à trouver une réponse adéquate, bien que souvent imparfaite, à une question difficile.

Que peut-on faire pour atténuer les biais ? Comment peut-on améliorer nos jugements et nos décisions ?

Faire évoluer son Système 1 demande énormément d’efforts. Le Système 1 est peu malléable.

De son côté, le Système 2 ne dispose pas d’un moyen simple pour faire le tri entre compétence avérée et heuristique. Sa seule solution est de se rendre compte qu’il est en terrain miné, de ralentir et d’essayer de construire une réponse de son propre chef.

Malheureusement, ce cheminement a peu de chance d’être mis en œuvre lorsqu’il est le plus nécessaire. La voix de la raison est souvent beaucoup moins audible que la voix puissante d’une intuition erronée et il est désagréable de remettre en question ses intuitions lorsqu’on est confronté au stress d’une décision importante.

Cependant, il est beaucoup plus facile d’identifier un champ de mines lorsque l’on observe d’autres personnes s’y aventurer que lorsque l’on est sur le point de le faire soi-même. Solliciter un avis extérieur peut ainsi aider à ralentir. Un observateur sera plus détaché d’un point de vue cognitif et sera plus ouvert à l’information qu’une personne dans l’action.

Les organisations sont ainsi souvent meilleures que les individus lorsqu’il s’agit d’éviter les erreurs. Elles pensent naturellement plus lentement et elles s’appuient généralement sur des procédures. Elles peuvent par exemple mettre en place des check-lists pour ne pas tomber dans les pièges tendus par notre Système 1. Suivre un process clair permet aussi d’éviter les prises de décisions trop rapides et trop émotives.

D. Kahneman pense par ailleurs qu’il est essentiel de mettre des mots précis sur nos biais pour en prendre conscience et mener une critique constructive. Des étiquettes comme l’effet d’ancrage, l’effet de cadrage ou l’excès de confiance, nous renvoient à ce que nous savons sur les biais, leurs causes, leurs effets et ce que nous pouvons faire pour y remédier.

Finalement, pour ne pas être victime de lui-même, un investisseur individuel a intérêt à tenir un journal de bord, consigner ses échecs, utiliser des check-lists et confronter son point de vue avec des personnes qui ne pensent pas comme lui (quoi de mieux que le forum des daubasses pour ça !).

Malgré ces stratégies, il est souvent difficile d’éliminer complètement les biais cognitifs, mais les atténuer peut améliorer de manière significative la qualité des décisions.

Si vous souhaitez approfondir ce sujet, nous vous recommandons la lecture des ouvrages « Système 1 / Système 2 : les deux vitesses de la pensée » de Daniel Kahneman, ou le livre d’Olivier Sibony, « Vous allez commettre une terrible erreur ».